L'architecture Fermi de Nvidia n'avait pas enchanté les foules lors de sa sortie en 2008 : les performances étaient là, mais au prix d'une consommation et d'une nuisance sonore élevées. Mais les choses ont changé en 3 ans : plusieurs modèles se sont succédé chez le constructeur, et Fermi a gagné énormément en maturité. Après avoir testé une Geforce 560 Ti de Club3D dont on vantait les mérites dans notre test, nous allons nous intéresser cette fois à une Geforce 560 « Non Ti ». Les cartes sont plus différentes qu'un simple suffixe, mais voyons ensemble si le rapport qualité/prix/fonctionnalité de cette Gigabyte overclockée d'usine GV-N56GOC-1GI est intéressant pour les gamers que nous sommes.

Caractéristiques techniques

Commençons par la fiche technique, telle qu'on peut la trouver sur le site officiel du constructeur :- Chipset Nvidia GTX 560

- Fréquence GPU : 830 MHz (au lieu de 810 MHz)

- Fréquence Mémoire : 4008 MHz (idem stock)

- Taille Mémoire : 1 Go

- Bus Mémoire : 256 bits

- Interface : PCI-E 2.0

- Type mémoire : GDDR5

- DirectX : 11

- OpenGL : 4.1

- Ports :

- mini-HDMI

- 1 x DVI-I

- 1 x DVI-I/DVD-D

- mini-HDMI

- Résolution max numérique : 2560 x 1600

- Résolution analogique max : 2048 x 1536

- Multi-view : 2

- Dimensions : H43 mm x L238 mm x W130 mm

- Alimentation requise : 500W, avec deux connecteurs PCI-E 6 broches (2 x 75 W)

- Prix : 174,99 €uros : chez notre partenaire materiel.net

Déballage

Le packaging est constitué d'une chouette image côté pile, représentant l'œil d'un robot, façon Transformers, et côté face, des principales features de la carte. C'est classique mais efficace.On voit notamment que la boite arbore la mention « Ultra Durable ». Chez Gigabyte, il s'agit d'un ensemble de choix de conception et de techniques qui ont pour but de faire en sorte que les cartes produites dépassent allégrement leurs dates de fin de garantie avant de défaillir. Par exemple, tous les condensateurs utilisés sur l'étage d'alimentation sont japonais, à la manière de ce qu'on trouve dans les alimentations ATX.

Ouvrons la boite, et observons maintenant la carte de plus près.

Gigabyte propose une carte qui s'éloigne du modèle de référence nVidia avec des fréquences revues à la hausse (830 MHz au lieu de 810 MHz pour le cœur, et MHz au lieu de MHz pour la RAM), et qui nécessite donc un refroidissement adapté. C'est un système double ventilateurs thermorégulés qui a été retenu et monté sur un radiateur aluminium à heatpipes en cuivre et qui est présenté sous le nom de « WindForce 2X ». Ce genre de refroidissement est courant sur les modèles overclockés, mais il a la particularité de disposer de ventilateurs inclinés. Gigabyte a également mis en place une chambre à vapeur (vapor chamber) entre le radiateur et le processeur, similaire à ce que fait Sapphire sur ses séries Vapor-X. On verra par la suite si ce système est silencieux tout en étant performant, mais on peut déjà observer sur les photos que le WindForce 2x a au moins l'avantage d'être relativement fin par rapport à d'autres cartes. La GV-N56GOC-1G utilise toujours 2 slots, mais dans l'hypothèse d'un SLI, il y aurait un passage d'air possible entre les 2 cartes.

Globalement, l'impression qui se dégage de la carte est une grande maitrise par le constructeur en termes de conception et de réalisation.

Au niveau des 3 sorties à l'arrière de la carte, on ne trouve pas de placage or inutile, et c'est tant mieux. Comme à l'accoutumée avec les cartes nVidia, on pourra brancher 2 écrans simultanément sur cette carte.

Coté bundle, non inclus dans notre exemplaire de test prêté par le constructeur, il se compose des éléments suivants :

- Manuel

- CD de drivers

- Adaptateur mini-HDMI -> HDMI

- Adaptateur DVI -> VGA

- Adaptateur Molex -> PCI-e

Installation dans la configuration de test

La configuration de test est la suivante :- Boitier Lian-li PC-V1020

- Alimentation Antec HGP 850W

- Carte mère Gigabyte P55A-UD3R

- CPU Intel Core i5 750

- 6 Go RAM DDR3 Crucial Ballistix Smart Tracer

- Ventirad Noctua NH-D14

- SSD Crucial M4 128 Go

- DD 1 To Samsung Spinpoint F1

- DD 1 To Western Digital Caviar Black 64 Mo

- Carte son X-Fi Pro Fatal1ty

- OS : Windows 7 X64 Intégrale

Partie logicielle

Drivers

On utilisera pour nos différents tests la version 290.36 Beta des Forceware, les drivers unifiés de nVidia fonctionnant pour toute la gamme GTX. L'interface de ces drivers est assez claire, comme on peut le voir sur les différentes captures :On peut noter que la configuration double écrans du PC de test s'est faite sans aucun problème, ce qui n'a pas toujours été le cas chez nVidia. Notons également que la fonctionnalité de mise à jour automatique est un ajout bienvenu. Paramétrable, elle permet de choisir notamment si on veut utiliser les versions beta ou se cantonner aux versions WHQL.

Easy Boost

L'outil Easy Boost de Gigabyte est compatible avec toutes les GTX de la marque. Il a pour objectif, comme on peut s'en douter, de tirer le maximum de la carte. Il suffit de regarder l'interface pour voir que rien ne manque, ou presque.Le premier onglet, affiché par défaut, permet de gérer les fréquences de fonctionnement et le ventilateur, ainsi que de voir le monitoring des sondes de températures. L'interface est claire, propre et intuitive. La seule chose sur lequel on ne peut pas agir, c'est le voltage du GPU, et c'est peut être mieux ainsi.

L'autre onglet qui peut avoir son intérêt est celui permettant de flasher le BIOS de la carte, directement sous Windows, comme cela se fait depuis des années pour les cartes mères. Les autres parties de l'interface, permettant de contacter le support notamment, sont de moindre importance.

Protocole de test

Dans les benchmarks seront opposés la nVidia GeForce 560 Ti OC de Gigabyte, à notre carte graphique de référence, à savoir une AMD HD 4870 overclockée Gainward Golden Sample, qui avait couté à sa sortie aux environs de 300 euros. On indiquera également pour comparaison les résultats obtenus par une GTX 560 Ti OC de Club3D. Ce sera l'occasion de voir si le suffixe « Ti » a tant d'importance que cela.En mettant les deux modèles de cartes côte à côte, on voit que la Gainward embarque également un système de refroidissement double ventilateur, prouvant ainsi que Gigabyte n'a rien inventé de particulier sur le concept, à part l'inclinaison des ventilateurs. Côté sorties disponibles, on trouve un avantage côté AMD, puisque la Gainward propose quatre types de sorties distinctes : vrai HDMI, VGA, DVI et Display Port. De manière générale, sur les cartes AMD plus récentes, c'est toujours le cas, et les Radeon gèrent par défaut le triple écran tandis que nVidia se contente du double écrans.

Sur le papier, les cartes sont un peu plus dissemblables qu'on pourrait le croire de prime abord. Les fréquences de fonctionnement sont certes plus élevées, pour la carte nVidia, mais la mémoire est identique en termes de type, de taille et de largeur de bus. Le support de DirectX 11, ainsi que de nouvelles fonctionnalité comme le PhysX sont bien entendu des différences notables, mais c'est surtout la différence de génération, et donc de l'efficacité de l'architecture entre ces cartes, qu'on va voir au travers des benchmarks.

Un petit tableau récapitulatif montre la différence technologique entre 2 générations de cartes, ainsi qu'entre les GTX 560 Ti et non Ti.

| ATI HD 4870 | Nvidia GTX 560 | Nvidia GTX 560 Ti | |

|---|---|---|---|

| Chipset | RV770 XT | GF114 | GF114 |

| GPU Clock | 775 MHz | 830 Mhz | 880 Mhz |

| Cores | Stream Processors : 800 | CUDA Cores : 336 | CUDA Cores : 384 |

| Memory Size | 1024MB | 1024MB | 1024MB |

| Memory Interface | 256 bits | 256 bits | 256 bits |

| Memory Type | GDDR5 | GDDR5 | GDDR5 |

| Memory Clock | 4000 MHz | 4008 MHz | 4100 MHz |

| Direct X | 10.1 | 11 | 11 |

La GTX 560 se différencie de sa grande sœur la GTX 560 Ti par des fréquences de fonctionnement un peu plus faibles, et par une unité de calcul supprimée, ce qui se traduit par 48 core CUDA de moins. Cela devrait donc se voir dans les résultats, sans toutefois entrainer une perte de performances catastrophique.

Le protocole de test sera composé d'outils de benchmarking synthétiques et de FPS populaires, à savoir :

Benchmarks synthétiques :

- 3DMark 2011(Direct X)

- Fur Mark (OpenGL)

Benchmark FPS :

- Arma2

- Stalker Call of Pripyat

- Metro 2033

Résultats et analyses

3Dmark 11

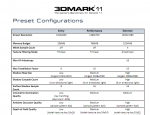

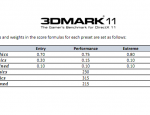

On ne présente plus ce benchmark sorti fin 2010, made in FutureMark. On utilise le mode « Performance », qui est le mode par défaut, ainsi que le mode « eXtreme » Les résultats 3Dmark comportent une note principale, qui est composée d'une formule de calcul agrégeant plusieurs sous-notes, correspondant en fait à différents aspects du rendu d'un jeu : moteur graphique et moteur physique. Le CPU n'ayant que très peu d'impact sur le score global, il n'y a plus de test uniquement CPU comme dans les précédentes versions de cet outil de benchmarking, il est désormais intégré aux calculs physiques.La 2eme capture montre la règle de calcul exacte, qui incorpore des coefficients d'harmonisation suivant les modes disponibles, visibles dans la 3e capture. L'objectif global de ces coefficients peut se résumer ainsi : plus le mode choisi est exigeant pour la carte graphique, moins le CPU à d'influence sur la note finale.

| Benchmark | Gigabyte GTX 560 OC | Club3D GTX 560 Ti OC |

|---|---|---|

| 3DMark | X1332 | X1573 |

Les 2 cartes se comportent de manière similaire, avec logiquement une avance réelle mais raisonnable pour la version « Ti ». On verra à la fin de l'article si un peu d'overclocking permet de renverser la tendance.

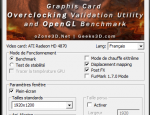

Fur Mark

Ce petit logiciel basé sur OpenGL donne des sueurs froides aux GPU. Il vise à reproduire de la fourrure en 3D, ce qui est très consommateur en ressources de calcul. Utilisé dans sa version 1.8.2, on le fera tourner pendant 1 minute en 1920*1200. Les résultats sont donnés sous 2 formes : en nombre moyen d'image par secondes et dans l'équivalent Fur Mark, qui est à l'instar de 3Dmark un nombre de points.| Benchmark | ATI 4870 | Gigabyte GTX560 OC | Club3D GTX560 Ti OC |

|---|---|---|---|

| FPS | 29 | 62 | 70 |

| Fur Mark | 1234 | 2868 | 3610 |

Là encore, la conclusion s'impose d'elle-même, puisqu'ici les résultats varient du simple au double dans ce test. Cela s'explique surtout par les différentes avancées technologiques embarquées dans la GeForce GTX 560. Le support OpenGL de cette carte est donc pleinement opérationnel. Les amateurs de jeux à base de moteurs idtech apprécieront. La GTX 560 Ti est un cran au-dessus, sans réelle surprise.

Essayons de vérifier si les différences de scores obtenues dans les jeux sont aussi tranchées que dans les tests synthétiques.

Arma2

Sous ArmA 2 , on utilisera une map spécialement conçue à des fins de mesures de performances, dénommée « BM_cityRun.Chernarus » et provient de l'outil ArmaFPSAnalyser. Elle comporte en fait des déplacements automatiques de la caméra, ce qui permet de simuler de manière ultra-précise, et reproductible, le déplacement du joueur. Côté paramètres, la résolution utilisée dans le jeu proprement dit est 1440 * 900 en qualité Très Haute. Le tableau suivant montre les résultats en termes de nombre moyen d'images par secondes :| Benchmark | ATI 4870 | Gigabyte GTX560 OC | Club3D GTX560 Ti OC |

|---|---|---|---|

| 25 | 33 | 36 |

La différence entre les cartes est visible dans ce benchmark, dans lequel on voit bien que malgré un paramétrage assez soft, le nombre de FPS n'est pas très élevé. Arma2 est un jeu au moteur gourmand, et il faudra prendre le temps de choisir les options graphiques pour voir l'impact sur les performances.

Stalker Clear Sky

Le jeu S.T.A.L.K.E.R. : Call of Pripyat et son moteur propriétaire X-Ray Engine ont toujours mis les machines à rude épreuve. On a décidé d'être un peu gentils, et de ne pas tenter de mettre à genoux les cartes. Il est à noter que l'outil de benchmark est un stand alone, il permet donc de mesurer les performances d'une configuration matérielle sans posséder le jeu, ce qui est très appréciable. Le tableau suivant montre les résultats en termes de nombre moyen d'images par secondes :| Benchmark | ATI 4870 | Gigabyte GTX560 OC | Club3D GTX560 Ti OC |

|---|---|---|---|

| Day | 63 | 83 | 89 |

| Night | 74 | 88 | 108 |

| Rain | 82 | 83 | 118 |

| Sunshaft | 46 | 63 | 75 |

On voit que les cartes s'en sortent bien, quelques soient les scènes, et les GTX obtiennent de meilleurs scores. On voit en revanche qu'il n'y a pas de doublement de performances entre les 2 générations de cartes graphiques comme on avait pu le voir dans les tests synthétiques, ce qui montre — s'il était encore besoin — de la différence entre le théorique et la pratique. Encore une fois, le positionnement de la GTX 560 est respecté par rapport à celui de la GTX 560 Ti.

Metro 2033

On utilise l'outil de benchmark bien pratique qui est intégré au jeu Metro 2033, sous forme d'un exécutable à lancer. Il dispose d'une interface graphique qui permet de configurer la scène et les paramètres à utiliser. Dans notre cas, c'est le niveau du jeu « Frontline » qui sera utilisé, à la fois dans un mode « normal », tel que défini par défaut en 1024 * 768, et un mode plus avancé qu'on nomme « zeden » en 1920 * 1200. Les résultats sont ensuite affichés dans une page web. Le tableau suivant montre les résultats en terme de nombre moyen d'images par secondes :| Benchmark | ATI 4870 | Gigabyte GTX560 OC | Club3D GTX560 Ti OC |

|---|---|---|---|

| Normal | 27 | 81 | 83 |

| Zeden | 17 | 23 | 34 |

Dans ce jeu assez exigeant, on voit que la HD4870 est en difficulté. Avec moins de 30 FPS en moyenne, le jeu ne se révèle pas facilement jouable sans descendre les options graphiques. Les GTX 560 Ti et non Ti sont largement plus à l'aise dans le mode Normal, mais on constate également que le mode Zeden leur cause aussi du souci. Mais avec 23 FPS, on pourra difficilement utiliser cette grande résolution sans investir un peu plus.

Températures, consommation et nuisances sonores

Obtenir des excellentes performances, c'est bien. Le faire dans le silence et sans trop consommer, c'est mieux. On mesure donc le bruit et le besoin en énergie de la GeForce GTX 560. On va donc soumettre la carte à un Burn-in réalisé avec Fur-mark, car OCCT n'avait pas l'air de vouloir fonctionner.Bruit

Pour mesurer les nuisances sonores, c'est notre fidèle Voltcraft SL-100 qui sera de la partie. Il sera placé à 50 cm de la façade de notre boitier Lian Li. Pour tout savoir sur les mesures avec cet appareil, une lecture de notre article dédié à ce sujet s'impose.Températures

On va utiliser l'outil GPU-Z qui permet de récupérer toutes les informations d'une carte graphique. Si on s'arrête un peu sur ce que l'outil affiche, on voit que la carte date de de fin janvier 2011, et qu'il y a 1950 Millions de transistors gravés en 40 nm. Grâce à cet outil, dans sa version 0.5.4, on peut lire notamment la température du GPU mais également la vitesse de rotation des ventilateurs de la carte graphique, ce qui est toujours très intéressant quand on le met en rapport avec les nuisances sonores mesurées.Consommation

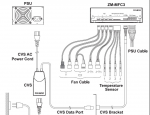

Pour mesurer la consommation globale de la machine, on utilisera un Zalman ZM-MFC3. C'est un rhéobus gérant 4 ventilateurs, mais qui a surtout la particularité de pouvoir afficher la puissance en entrée d'alimentation. En fait, le Zalman utilise un boitier spécifique de mesure, dénommé CVS pour Current/Voltage Sensor, qui est à placer avant la prise 220V de l'alimentation. Un câble, ressemblant à de l'USB, part ensuite de ce boitier et va jusqu'au rhéobus en traversant toute la tour. L'affichage est temps réel et en W, ce qui permet une lecture instantanée. La limite de 999 W ne devrait pas beaucoup nous gêner.Résultats et analyse

| Charge | Température (°C) | Vitesse rotation ventilateur (%) | Bruit (dB) | Consommation (W) |

|---|---|---|---|---|

| Idle (1 écran / fréquences de base) | 26 | 50 | 38.8 | 135 |

| Idle (2 écrans / fréquences de base ) | 35 | 50 | 38.8 | 175 |

| Idle (2 écrans / OC 990/1180) | 36 | 50 | 38.8 | 180 |

| Pleine charge (fréquences de base) | 52 | 50 | 40.4 | 303 |

| Pleine charge (OC 990/1180) | 60 | 60 | 42.4 | 303 |

Au vu de ces chiffres, il y a plusieurs choses à dire.

Premièrement, on voit qu'activer ou pas un 2e écran à un impact sur la consommation sans charge. En fait, l'impact se fait sur les fréquences utilisées en idle. Avec un seul moniteur, la GTX560 réduit la fréquence de son cœur à seulement 50 MHz ! Les constructeurs ont bien compris qu'il est vraiment inutile de faire tourner la carte à fond quand le PC ne fait rien. Malheureusement, le 2e écran empêche ce fonctionnement, et la consommation augmente de 40 W. On voit en revanche que l'OC n'a qu'un effet limité sur la ponction d'énergie à la prise murale : seulement 5 W. A noter également qu'overclocker les fréquences maximales n'a pas d'impact sur les fréquences réduites en mono écran, lorsque la carte est en idle.

En charge, la consommation passe à près de 303 W, c'est 2 fois moins que ce que le constructeur recommande. On pourrait donc presque faire un SLI de GTX 560 avec un bloc de 600 W, pour peu que celui-ci offre 4 ports PCI-E 6 broches.

Alors que la température augmente de 35°C, la ventilation n'augmente elle que de quelques points de pourcentage. Cela permet de garder un niveau de nuisance sonore plus qu'acceptable, puisque la différence de niveau sonore mesurée est faible. Cela veut dire que normalement, il serait possible de baisser encore plus la vitesse de rotation des ventilateurs en idle pour faire encore moins de bruit. Ce n'est pas possible par défaut dans le driver, mais il y a des applications pour ça, suivant l'expression consacrée, notamment Easy Boost.

Overclocking

Il serait dommage de passer outre l'aspect overclocking de cette carte. En effet, le constructeur fait tout pour qu'on ait envie de pousser les fréquences, et cela commence dès le dos de la boite, où il est indiqué que le potentiel d'augmentation est compris entre 10 et 30 %. Les chiffres qu'on peut voir apparaitre dans différents tests de GTX 560 sur la toile sont compris dans cette fourchette. Le forum [H]ardOCP a compilé ces résultats, et voilà ce qu'il en ressort :| Élément | OC min (MHz) | OC max (MHz) | OC moyen (MHz) |

|---|---|---|---|

| Core | 913 | 1044 | 971 |

| RAM | 1027 | 1252 | 1176 |

Cela donne une bonne idée de ce qu'on peut attendre.

En pratique, après plusieurs tâtonnements, validés par des exécutions de 3DMark 2011 pour valider, nous avons atteint avec notre exemplaire de test les fréquences suivantes :

- Core : 990 MHz, soit 22 % de mieux que la fréquence de base du GTX 560.

- RAM : 1180 MHz, soit 18 % de mieux

Conclusion

Le modèle proposé par Gigabyte est très bien adapté au segment des joueurs peu fortunés voulant disposer d'une carte graphique combinant dernières technologies, et performances pour un prix inférieur à 200 Euros. Facilement overclockable à l'aide de l'outil Easy Boost qui est une petite merveille, cette GTX 560 vient titiller sa grande sœur vendue quelques dizaines d'euros plus cher. Il n'y a qu'un seul conseil à formuler : foncez !

![]()